Revolution 1: Der totale Feedbackloop (in Computergames)

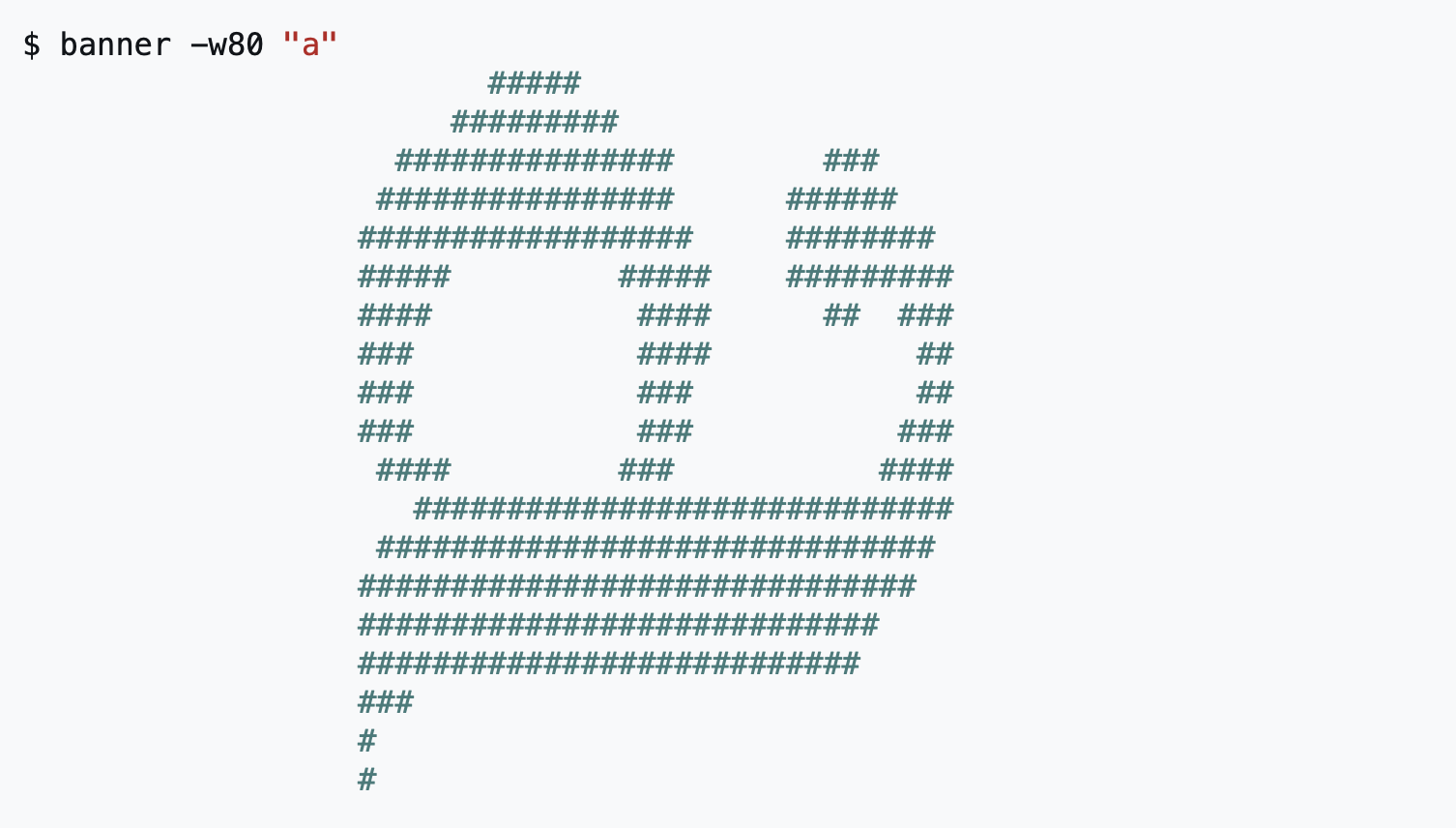

Computer waren am Anfang SingeUser-Maschinen. Ein Mensch bediente sie und sie rechneten dann etwas. Schon hier tritt eigentlich ein Kreislauf in Aktion: Mensch-Maschine und wieder von vorne. Anders als bei anderen Medien, die vom Menschen betrieben wurde, gab es hier kein Müde oder Aussetzen, es lief immer weiter. Und aus dem Stop&Go-Programmen der Anfänge – Input > Output entstanden interaktive Umgebungen. Das Programm konnte rückfragen, der User antworten (Siehe BASIC Version 1.0 Darthmouth).

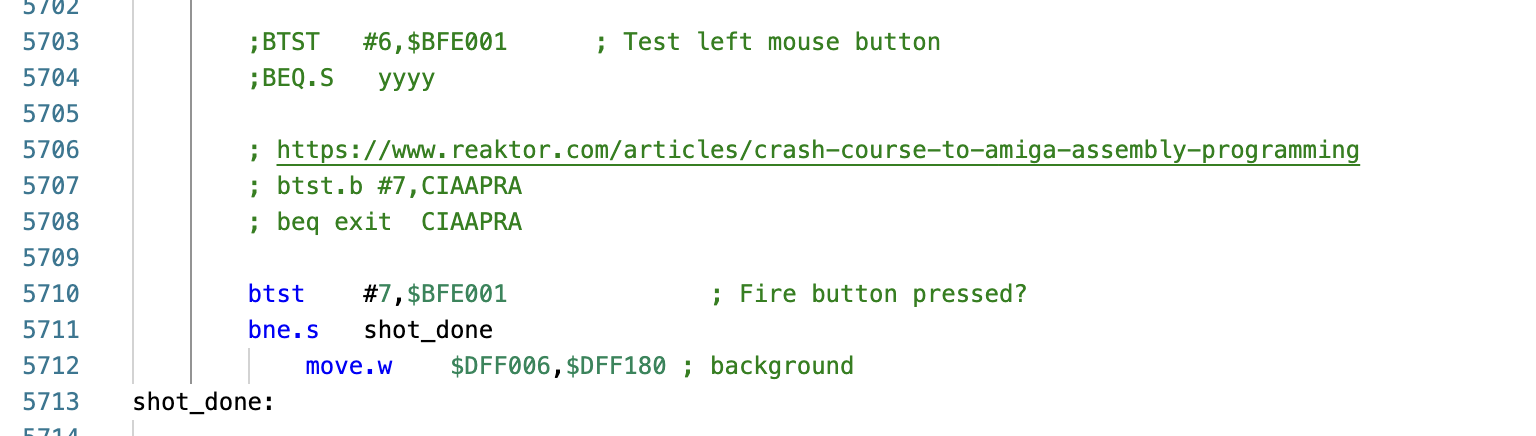

Auch dieses Modell wurde verfeinert, jetzt wurde es möglich auch Keys abzufragen (etwa bei PLATO System schon sehr früh). Die Maschine wurde nebenläufig.

Der kybernetische Feedbackloop war damit geschlossen. Der Mensch Teil einer Maschinerie oder eher die Option in der Maschinerie. Dies schlug dann mit den Homecomputer nochmals krass durch. Und zwar nicht nur als Entwickler* von Text, Music, Graphik und Software. Sondern ganz besonders bei Spielen, die diesen kybernetischen Feedbackloop mit den Gameloops von Spielen kurzschlossen und nun Spiele ermöglichten mit 100 Stunden Spiel theoretisch am Stück. Es war anders gesagt nun ein zweifacher Spielkreislauf. Das totale Spiel. Und so wundert es auch nicht, dass gerade in den 80er Jahren das SinglePlayer-Game die Erfindung jener Jahre war. Ein Endlosfeedbackloop.

Revolution 2: Vernetzte Feedbackloops für Tausende

Bis zur Einführung von Time-Shared-Computing und Terminals in den 60er Jahren konnte nur eine Person einen Computer bedienen. Danach konnten es 100te ‚gleichzeitig‘. Diese Entwicklung wirkt noch bis heute nach. Denn Heute bedienen wiederum einzelne Computer / Mainframes / AIs tausende von Leuten und das vernetzt.