Nicht adäquate reverse Diskursanalyse vom Besten alias LLM Google-AI

Schreibe eine Antwort

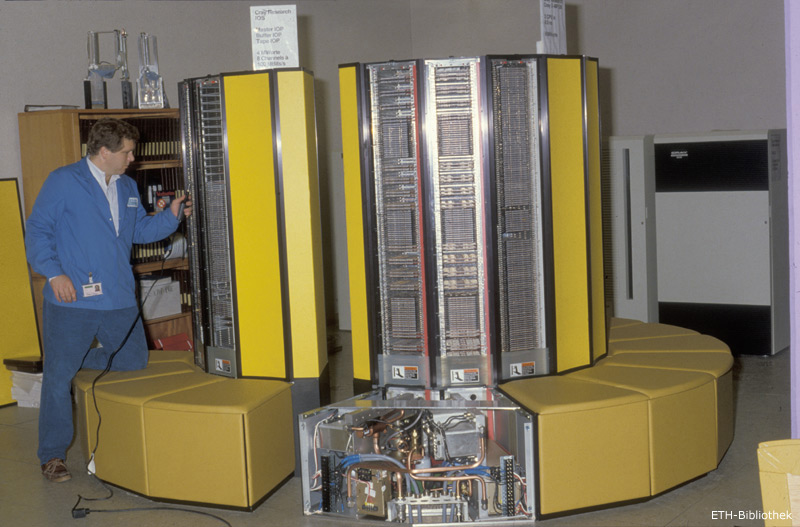

Die Virtualisierung war etwas, was Mainframes schon von Anfang an technologisch betrieben. Zum Einen virtualisierten sie sehr früh mit RAM – den Zugriff auf ihren Arbeitsspeicher mit Random Access Memory. Danach virtualisierten viele Mainframes ihre Input/Output-Geräte mittels Keyboards und Displays. Dann virtualisierte man bald den User mit Multiusersystemen. Gleichzeitig gab es gesharte Rechenzeit für die verschiedenen User and verschiedenen Terminals! Dadurch entstand letztlich als Multitasking der Server, der eigentlich auch eine Virtualisierung ist.

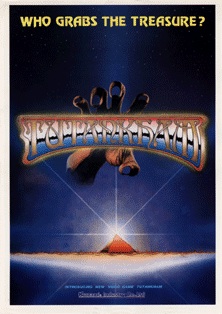

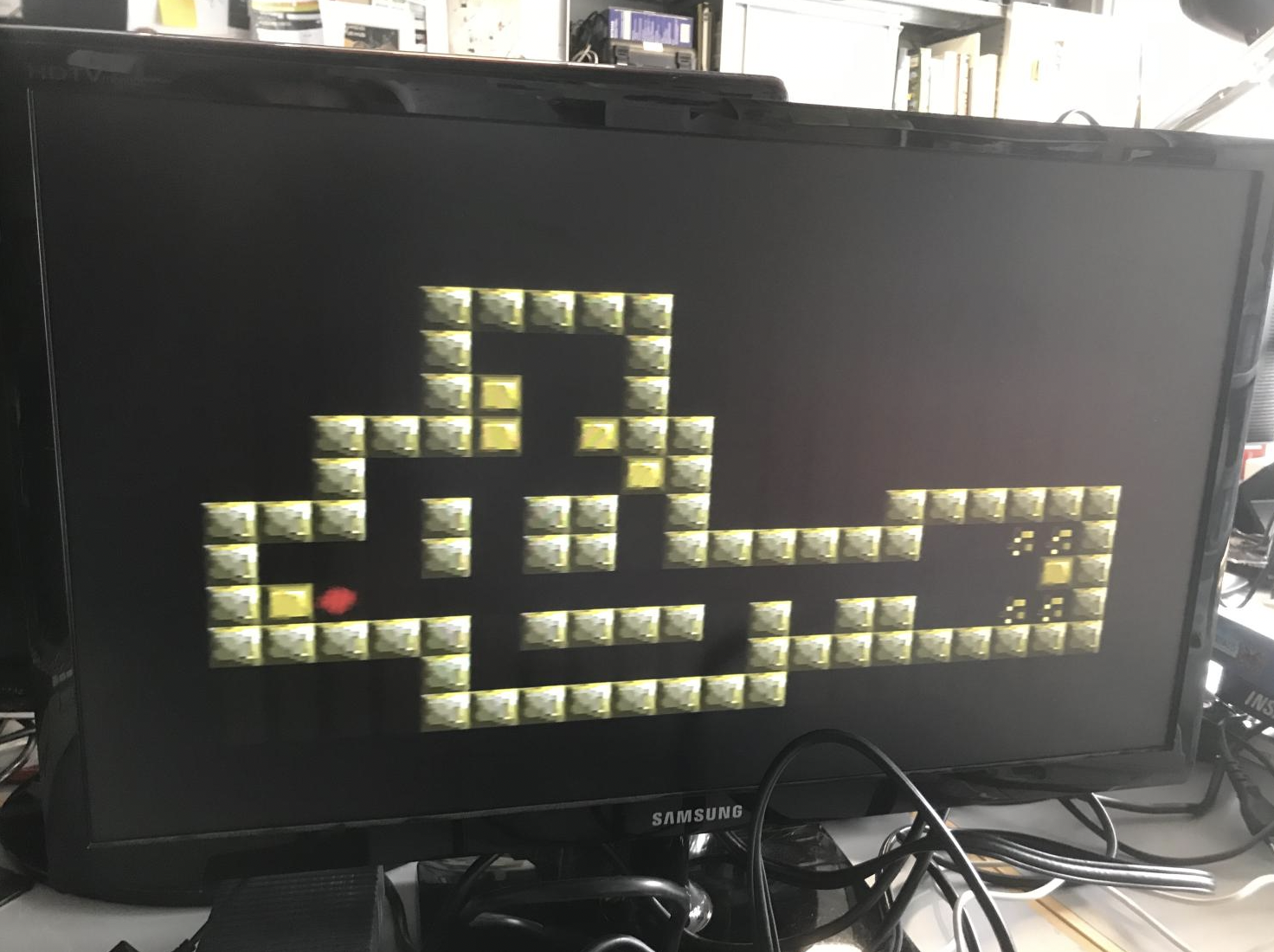

WeiterlesenTimeBandit ist ein interessantes Spiel mit seinem „Postmodernen Mix“. Es kam 1983 heraus und wurde für die 68kler nochmals kräftig upgedatet.

Zeitzeuge: TimeBandit war damals ungemein faszinierend. Ich sah es das erste Mal an einer Ausstellung (da gab es so einen Consolen/Computerecken vgl auch CHLudens Interview mit Heubi/Kohler) im Technorama auf einem Atari ST in Winterthur mit meinen Geschwistern und wir waren fasziniert. Dieser heute krude Mix. Das Spiel war damals nicht einfach lesbar wie später Gauntlet. Die Zeichen stammten nicht aus einer Welt sondern waren gemixed. Es ging durch seltsame Welten mit unterschiedlichsten Settings und das scheinbar gleichzeitig und nicht als Entwicklungsgeschichte wie anderen Spielen. Auch das Ziel des Spiels war unklar – es schien offen mit Übersichtsleveln und dann einzelnen Welten darin. Irgendwie. Und alles im selben Look.

Time Bandit beruht offensichtlich auf dem Arcade Tutankham 1982 (https://en.wikipedia.org/wiki/Tutankham).

Hier ist man* unterwegs in einer Pyramide und sucht nach „Schätzen“. Die Artefakte oder Geschichte interessieren hier auch nur nebenbei. Damit folgt das Spiel auch etwa der Film Indiana Jones 1981 – auch dieser interessiert sich für Geschichte ja nicht wirklich. Denn warum raubt Indiana Jones all die Artefakte? Weil andere es zuerst rauben würden? Und dennoch findet er sie vorher, um sie nach London zu bringen ins koloniale Museum? Es geht auch um Ruhm für sich.

WeiterlesenDieser Themenindex findet sich hier: https://research.swissdigitization.ch/?page_id=2

Darum findet man bis bis heute Tilebased Games (oder in der Abschwächung zumindest GridBased Games).

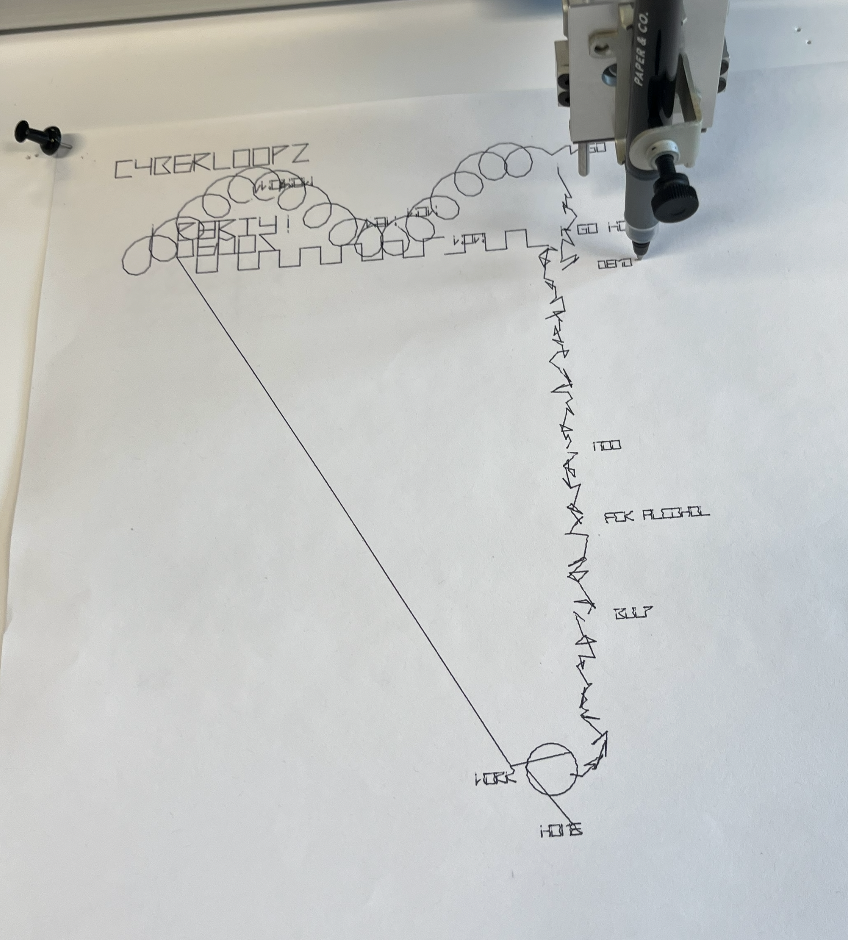

[DemoScene]

Lets go back to the 60ies/70ies, when digital Computing was done in big digital Mainframes.

This is a demo that tries to bring back the time, when Screen were not there or a lot too expensive and the only Displays were TypeWriters alias TeleTypeTerminals. This is a demo with a plotter. But also in the 8Bit-Time you could buy Plotters and make demos with them. If you are more interested in Plottergames – so look at PotShot or our Plottergames with AxiDraw here. So let’s beam back to the 70ies.

WeiterlesenIn den 90er Jahren entstand nach der Erfindung des WorldWideWebs langsam eine neue Platform für Spiele, hier WebGamePlatform genannt. Wie entwickelte sich diese? Wie unterscheiden sie sich und welche Spiele finden sich im CHLudens-Korpus dazu?

// Siehe dazu auch hier https://research.swissdigitization.ch/?p=7020

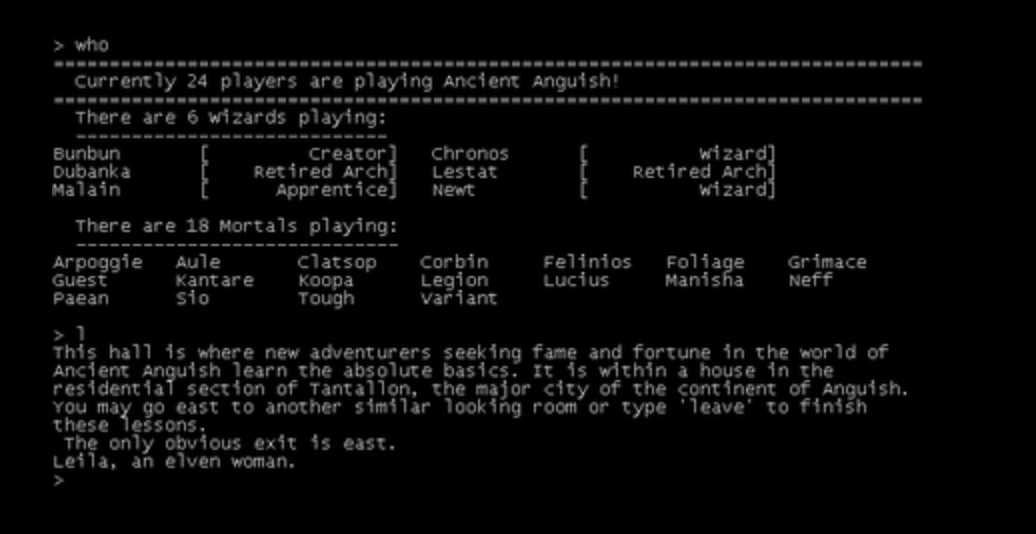

Selbstverständlich gab es schon immer Spiele, die an Telefonleitungen oder im Internet (IP-Based) standen. Angefangen bei Spielen für Mainframes wie etwa Plato Systems etwa das Leiterlispiel an einem ETH Rechner remote (siehe Interview CHLudens Korpus), Später MUDs (zu CH-MUDs siehe hier https://vintagecomputing.ch/?browseid=9291), direkt Telefon basierte Spiele (vor Ort anrufen) oder dann Spiele für BBSen (DoorGames).

Siehe dazu auch das Interview mit Roger Sieber, der in CH ein solches Spiel lange betrieb. All diese Plattformen waren mehr oder minder proprietär. Klar gab es einen VT52 Standard etwa bei BBSsen, Aber diese Systeme waren mehrheitlich festdefinierte einfache FrontEnds ohne eigene FrontEndLogik.

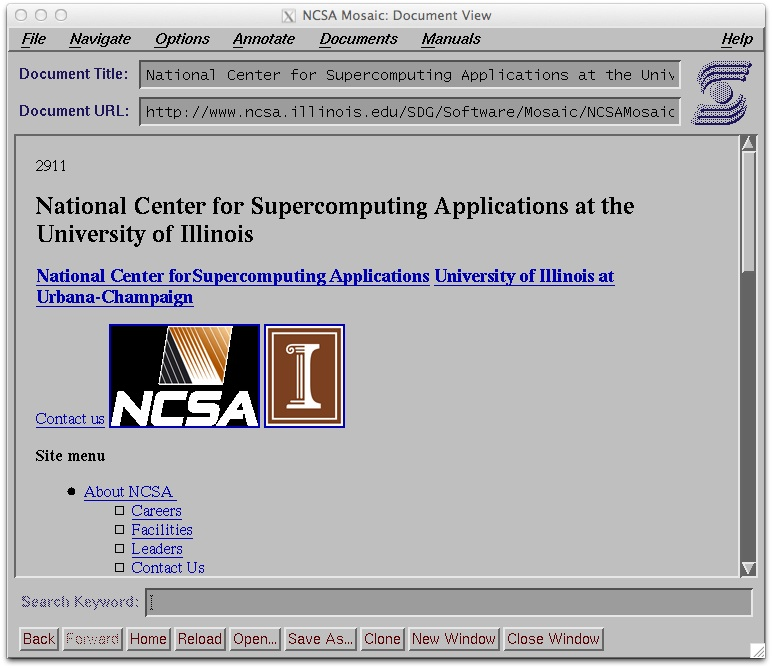

Dies änderte sich mit dem WWW zuerst einmal nicht. Es war ebenfalls ein Frontend mit eigenen interaktiven Möglichkeiten wie Links und Forms.

// Mosaic Browser https://en.wikipedia.org/wiki/NCSA_Mosaic

Weiterlesen

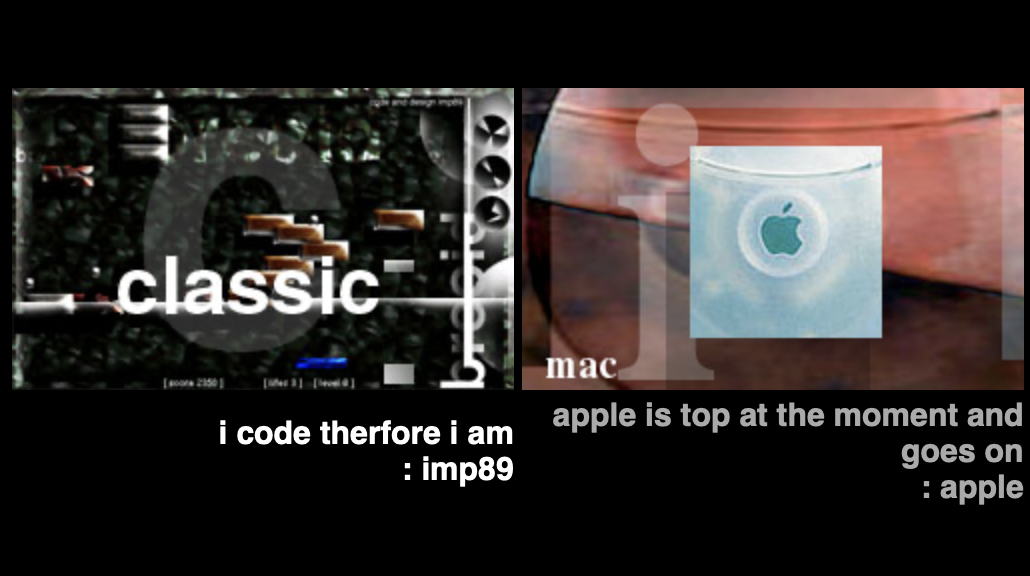

Neben einem Online-Tetris auf der Impression89-Webseite gibt es es interessanterweise ein ganzes Arsenal von WebGames (Games die in irgendeiner Weise das WordlWideWeb nutzen vorallem Ingame) von Imp89 in der Designers-Republic.ch Webseite mit einer ganz eigenen Ausrichtung dieses Mal nicht auf MacinthoshGames sondern auf Webgames.

Siehe dazu auch (Vermutlich) Letzte Version der Imp89 Webseite (1997?) & die „Nachfolgeseite“ Designers-Republic.ch [Erfahrungsbericht] https://research.swissdigitization.ch/?p=6774

Reine damals Javascript-Variante von Tetris. Das Ganze hat vordefinierte Tiles/Bilder. Diese werden dann ersetzt damit dies zu dieser Zeit spielbar ist. Funktioniert interessanterweise noch heute einwandfrei. Damals – als das WWW noch mit Übernahmen WorldWideWeb hiess (Datenübertragungen von 30Bytes pro Sekunde waren keine Seltenheit, ging es einige Zeit bis die Grafiken geladen wurden.

Spielmechanik: Das Tetris selbst funktioniert wie jedes Tetris auch, nur dass es rein per Maus mit Knöpfen steuerbar ist.

Visuell: Visuell orientiert es sich am Design von Imp89-Macintosh-Games.

Weiterlesen

Dies ist eine Durchsicht der von Imp89/Impression89 entwickelten Software im Bereich Demos und Games. Dabei wird auf die Games/Demos eingegangen und versucht diese zu kontextualisieren. Es zeigt sich dabei die Abhängigkeit von der Hardware gut, da gerade der Bruch vom ATARI ST zum ATARI STE spür- und erlebbar ist (Scrolling, Blitter, Digisound). Dabei zeigen sich schon Trends und Ideen, die später bei Imp89 auf dem Macintosh dann weitergeführt wurde.

Weiterlesen