Eine der grössten Probleme an Assembler-Programmierung ist die Nachvollziehbarkeit nach der Erstprogrammierung. Es ist dabei wie bei PERL – das ganze ist schwer nachvollziehbar. Einige Gründe: Immer sehr an Assembler und damit dem Prozessor. Einfachste Dinge (in Hochsprachen) werden in verschiedenste Schritte aufgeteilt und es muss praktisch immer verstanden werden, was ist in D0 gerade?

Es ist wie wenn man in einer höheren Programmiersprache bestimmte Dinge nur in 8+8 Variablen (68kProzessor) rechnen könnte.

Oder noch konkreter: Es gibt einen TaschenRechner in der Mitte, da kann man Dinge rechnen. Im Fall eines 8Bit Computers sind das dann nur +1, -1 und dann muss man es wieder wegschieben. Dann kommt das nächste dran. Das funktioniert nur, weil man es programmieren kann.

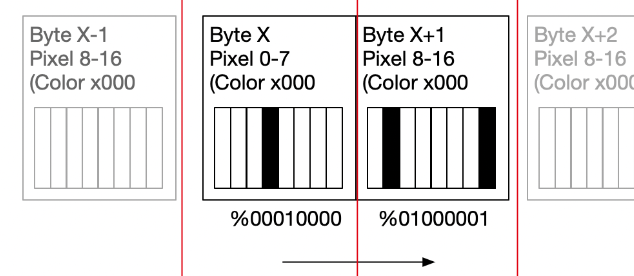

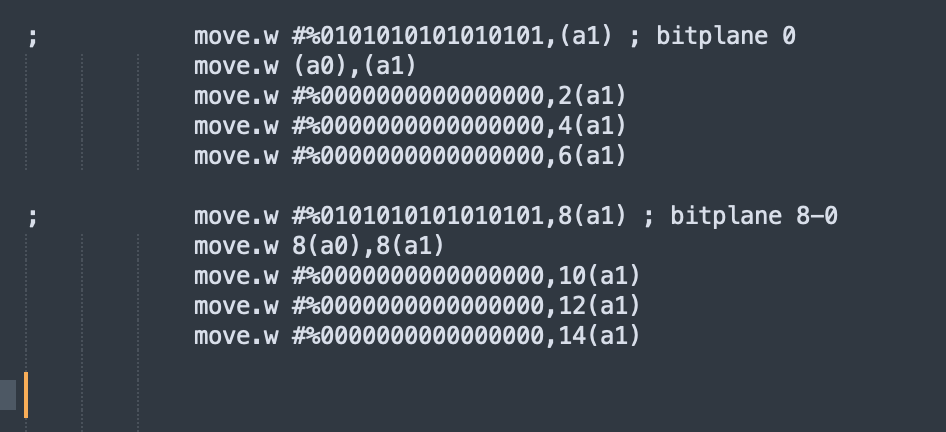

[RECHNERCODEA]

Variabeln/Memory ----> [RECHNER]----->Variabeln/Memory

[RECHNERCODEA]

AssemblerCoding ist in einem gewissen Sinn, ein Arbeiten mit sehr wenigen Funktion. In einem 8Bitter etwa.

incrementA()

incrementX()

incrementY()

copyAX();

copyXA();

copyYA();

copyVarToAdress(var);

copyAToAdress(var);

…

compareA();

compareX();

etc.

dadurch wird der Code lange, repetitiv und schlecht wartbar.

// ToDo: ActionCoding-Beispiel

// ToDo: Eine solche höhere Programmiersprache!